Виды уникальности текста

Что такое уникальность текста? Если верить биржам контента, то уникальность текста – это процентный показатель «непохожести» текста на те, что уже размещены в интернете и проиндексированы поисковиками.

Уникальность текста определяется специальными программами методом шинглов (поиск в Интернете копий последовательности слов, которые встречаются в проверяемом тексте).

Уникальность контента – один из обязательных критериев, необходимых в деле продвижения веб-ресурсов.

Теперь, когда классическая версия определения уникальности приведена, можно переходить к возражениям и дополнениям. Во-первых, то определение, которое мы видели выше, относится исключительно к технической уникальности текста. И только к ней.

Есть еще так называемая смысловая уникальность текста, которая для большинства современных бирж играет роль красной тряпки, но которая все чаще является сегодня главным критерием качества контента.

Техническая уникальность

Давайте начнем издалека. Итак, уникальность техническая. Была создана как способ борьбы с плагиатом на ранних этапах становления Сети. В ту пору, когда поисковые алгоритмы были не настолько умны, чтобы понимать смысл текста, но уже имели возможность находить дубли словосочетаний в поисковой выдаче.

Техническая уникальность долгое время действительно являлась (и в какой-то мере является сейчас) минимальной гарантией от санкций поисковых систем, была некоторым преимуществом в борьбе за поисковую выдачу. Подавляющее большинство бирж контента и программ проверки уникальности текста ориентируются именно на метод определения технической уникальности.

От нас скажем, что это самый простой способ оградить клиентов бирж контента от покупки неуникального материала: программа делает проверку, если текст технически уникален, он получает одобрение биржи и считается более-менее качественным.

Минусы технической уникальности текста стали ясны уже очень скоро: Сеть наводнили сотни вариаций одних и тех же авторских статей, переписанных на все лады. Рунет (и вся Сеть в целом) начали заполняться совершенно некачественным материалом, который не нес в себе ничего нового. Достижение технической уникальности производилось (и производится) путем перестановки слов местами, добавления синонимов, минимальной переделки смысловой структуры материала.

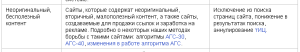

Поисковые системы, осознав, в какую помойку превращается их выдача, начали бороться с плагиаторами. Прошу внимательно взглянуть на скриншот:

Да-да, сегодня Яндекс уже умеет определять – был ли текст написан автором или даже это какой-то очередной, может быть даже тысячный рерайт. Конечно, алгоритм еще несовершенен, но подвижки уже радуют. Более подробно о добавочной ценности контента здесь.

Время смысловой уникальности

Как люди, занимающиеся не только написанием текстов, но и продвижением собственных ресурсов, можем засвидетельствовать: поисковики все лояльнее и теплее относятся именно к текстам, уникальным в смысловом плане. То есть не рерайту с заменой слов синонимами, а совершенно новым материалам, взятым исключительно «из головы».

Скажу больше, техническая уникальность таких текстов может быть не слишком высокой (избыток цитат, скажем), но на ранжирование материала это не влияет. Наоборот, мы неоднократно наблюдали, как авторские статьи, ни одна из которых не проверялась специальными программами, нередко обгоняли рерайтинг во всех его видах.

Пожалуй, из всех известных программ проверки уникальности только text.ru работает по алгоритму, предусматривающему именно смысловой, а не шингловый поиск. За это проверку на этом сайте так не любят сотни рерайтеров: с шинглами уникальность зашкаливает, а text.ru явно пишет, что текст – плагиат и рерайт с минимальной уникальностью.

Так что если клиент отходит от стандартных процедур и просит уникальность по text.ru, для рерайтеров "шингловой" школы частенько наступают черные дни. Впрочем, как мы слышали, наиболее продвинутые рерайтеры уже научились искусственно завышать уникальность и по Text.ru.

Что же, будем ждать ответа поисковиков и нового витка противостояния. Вот и все друзья, что нужно в общих чертах знать о видах уникальности текста.

Добра вам!

(21 оценок, среднее: 4,67 из 5)

(21 оценок, среднее: 4,67 из 5)

Я несколько раз проверял свои сугубо авторские статьи в разных программах. Так вот, и они умудрялись быть неуникальными. В общем, плюнул я на это дело. Но, когда заказчик настоятельно требует уникальности, проверяю материал во всех трех программах. Петр правильно заметил: они действительно работают по-разному и, в принципе, у каждой из них есть полезные “примочки” помимо проверки на техуникальность.

Частенько балуюсь рерайтом, когда нет других заказов. Однако при этом на текст.ру – после пары правок даже текст с уникальностью в 60-70% внезапно становится абсолютно уникальным, хотя было поправлено хорошо если 20% того, что он там навыделял. 🙄

Ошибка самого анализатора? Или же этими 20% и добивается смысловая уникальность?

У меня тоже на text.ru всегда лучше получалось.

Но заказчики чаще всего зациклены на адвего.

У меня на text.ru почти всегда было 100 % уникальности, грех жаловаться…

Если честно, то не знала даже про это. Интересненько. 😆

Ох, Пётр, ваши бы мысли, да заказчикам в голову.

94% уникальности, да вы плагиатор! Обвинял копирайтера заказчик, не замечая, с какой жадностью «пауки» анализируют размещенный текст.

Минуточку…пора писать книгу не по обучению копирайтеров, а по обучению заказчиков!

Полностью согласен с Вами, Петр. В который раз вспоминаю ситуацию из личного опыта и удивляюсь. Несколько лет назад довелось мне написать статью на достаточно специфическую тему, информационную базу для которой пришлось искать в печатных изданиях и видео-материалах. В итоге получился очень годный гайд, аналогов которого на момент публикации не было даже на иностранных сайтах. Буквально пару недель назад искал эту самую статью и совершенно случайно наткнулся на десяток страниц с рерайтом моего текста. 😐 Но вся фишка в том, что все без исключения копии исходного материала были далеко не в топе по выдаче. Первые 3-5 ссылок вели, как мне кажется,… Читать больше »